-

Financiële administratie & outsourcing

Ondernemers die de financiële administratie uitbesteden verminderen de administratieve en hebben meer tijd en ruimte om zich te focussen op groei.

-

Financieel inzicht

Wij helpen je om financiële gegevens om te zetten in waardevolle inzichten die je ondersteunen bij het nemen van weloverwogen beslissingen.

-

Financiële compliance

Grip op financiële compliance met correcte rapportages en praktisch advies.

-

Duurzaamheid in het mkb

In een wereld waar duurzaamheid steeds meer centraal staat, is het essentieel voor mkb-ondernemers om hun bedrijfsvoering aan te passen aan de eisen van de toekomst.

-

Impact House

Hoe kun je verduurzamen en maatschappelijke impact maken in de wereld van stakeholders, regelgeving en de vraag vanuit klanten en de maatschappij?

-

Impact Campus

Via onze Impact Campus bieden we jou of jouw medewerkers workshops, cursussen en opleidingen in duurzaamheid en impact aan.

-

Business risk services

Ken ik mijn risico’s? Neem ik de juiste maatregelen? Ben ik effectief daarin, ook met IT-tools? Als u met dergelijke vragen worstelt, kunnen wij u helpen met onze reeks van business risk diensten.

-

Cyber risk services

Welke cyberdreigingen zijn relevant voor mijn organisatie? Heb ik de goede voorzorgsmaatregelen genomen om mijn data te beschermen? Realistisch vragen! Wij helpen die te beantwoorden.

-

Deal Advisory

Succesvolle transacties beginnen met betrouwbare adviseurs – maximaliseer waarde, minimaliseer risico’s en met vertrouwen vooruit.

-

Forensic & integrity services

Hoe kunt u op verantwoorde wijze risico’s beheersen indien sprake is van integriteitinbreuken of bedrijfsfraude? De Forensic & integrity services specialisten van Grant Thornton helpen.

-

Valuations

Het bepalen van de juiste waarde van jouw onderneming is cruciaal bij belangrijke beslissingen zoals fusies, overnames, aandeelhouderswisselingen of juridische geschillen. Een onjuiste waardering kan leiden tot financiële verliezen, ongunstige deals of juridische complicaties. Dit kan de stabiliteit en groei van jouw bedrijf ernstig beïnvloeden.

-

Controle jaarrekening

Als ondernemer wil je er zeker van zijn dat je jaarrekening volledig en betrouwbaar is. Dit is niet alleen belangrijk voor compliance, maar versterkt ook het vertrouwen van investeerders, klanten en andere stakeholders.

-

IFRS services

Financiële verslaglegging volgens IFRS is ingewikkeld. Inmiddels kennen steeds meer internationale ondernemingen de regels. Hoe past u ze echter concreet toe?

-

Belastingadvies voor het mkb in Nederland

Hoe kan ik gebruikmaken van de innovatiebox? Kan ik die steeds terugkerende belastingaangiftes uitbesteden? Wat kost het als ik morgen wegval? Hoe regel ik mijn oudedagvoorziening? Voldoe ik wel aan alle nieuwe regelgeving? Zal ik NOW3 aanvragen? Allemaal goede vragen. Wij helpen met de antwoorden.

-

Belastingadvies voor Nederlandse multinationals

Als ik die interessante Head of sales in Frankrijk wil aannemen, hoe zit dat dan fiscaal? Welke vennootschap kan het beste een overname doen? Hoeveel scheelt het, als ik al onze belastingaanslagen wereldwijd bij één partij neerleg? Voor wie kan ik gebruikmaken van de 30%-regeling? En hoe? De boete van ‘niet melden’ 830.000 euro? Wat moet ik precies wél melden bij grensoverschrijdende fiscale constructies? Goede vragen. Wij beantwoorden er dagelijks honderden wereldwijd. Scherp en met aandacht voor uw situatie. In welk land dan ook.

-

Btw-advies

Als ondernemer heeft u te maken met btw-wetgeving, zowel als u nationaal als internationaal onderneemt. Die wetgeving is vaak complex. Een juiste toepassing en optimale benutting van de mogelijkheden van de btw-wetgeving vraagt specialistische kennis. Kennis die wij u kunnen bieden.

-

Douaneadvies

Ons internationale netwerk van douanespecialisten wijst u op de mogelijkheden die de douanewetgeving kan bieden. Dat bespaart u heel wat kosten en moeite.

-

Innovatie & subsidieadvies

Gaat u met uw organisatie risicovolle projecten aan? De overheid stelt financiële middelen beschikbaar, door middel van het stimuleringsbeleid, voor ondernemers. De subsidieadviseurs van Grant Thornton adviseren en assisteren u graag bij uw subsidieaanvraag.

-

Tax technology

Weet u wat uw belangrijkste fiscale risico’s zijn? En weet u hoe u deze risico’s identificeert en beheerst? Heeft u voldoende tijd om u te focussen op de fiscale zaken die ertoe doen?

-

Transfer pricing

Transfer pricing (interne verrekenprijzen) raakt de meeste multinationale bedrijven. Voldoet uw organisatie aan de transfer pricing-documentatieverplichtingen?

-

Sustainable Tax

In deze veranderende wereld wordt het steeds belangrijker om niet alleen naar de financiële prikkels te kijken, maar ook naar de impact op het milieu. Multinationale ondernemingen moeten hun belastingstrategie herzien, in lijn met het ESG-gedachtegoed.

-

Cryptocurrency en digitale activa

In de afgelopen jaren heeft de blockchain zichzelf bewezen om veranderingen teweeg te brengen in de financiële sector. Deze opkomende industrie heeft de noodzaak om aan regelgeving te voldoen, vergroot. In dit dynamische landschap passen onze specialisten zich hierop aan en geven zij voorrang aan de naleving en toezicht van de steeds veranderende regelgeving.

-

Private wealth services

Hoeveel vermogen heb je nodig om je wensen de komende jaren te realiseren? Kun je belastingvoordeel behalen door nu al vermogen over te dragen?

-

Ondernemingsrecht

Van algemene voorwaarden tot juridische strategie, het moet waterdicht in elkaar zitten. Dat geeft zekerheid en dus rust en ruimte voor groei. Wij denken pro-actief en pragmatisch met u mee. We kijken vooruit en zetten graag dat stapje extra.

-

Arbeidsrecht

Welke verplichtingen heb je bij een zieke werknemer? Hoe pak je een reorganisatie aan? Als ondernemer wil je duidelijke antwoorden en praktische oplossingen voor jouw arbeidsrechtelijke vragen.

-

Sustainable legal

Duurzaamheid is meer dan een buzzword - het vormt de kern van onze juridische begeleiding naar duurzaam succes. Van het opstellen van duurzame contracten, integreren van duurzaam HR-beleid en ESG-Due Diligence binnen onze M&A praktijk tot het adviseren over ESG en andere (nationale en internationale) wetgeving: Wij denken graag pragmatisch en proactief met u mee.

-

HR-services

Met de diensten van HR-services ben je standaard voorzien van een personeels- en HR-administratie van hoge kwaliteit, goede HR-begeleiding en het juiste (internationale) advies.

-

Arbeidsvoorwaarden advisering

Met een goed beloningsbeleid bind en behoud je werknemers aan jouw onderneming. Dit draagt bij aan het goed functioneren van jouw onderneming en ondernemingsstrategie. Onze Human Capital Services specialisten adviseren jou hier intensief bij.

-

Loonbelasting

Als werkgever draagt u loonbelasting en premies werknemersverzekeringen af over het salaris van uw werknemers. Uit de salarisadministratie volgt de hoogte van de in te houden loonbelasting. Die inhouding is echter afhankelijk van meerdere factoren.

-

Sociale verzekeringen

Hoe voorkom ik onverwachte heffing van premies werknemersverzekeringen?

-

Personeels- en salarisadministratie

Hoe organiseert u uw personeels- en salarisadministratie zo efficiënt mogelijk? Om snel inzicht te hebben voor uzelf en uw stakeholders (zoals verzekeraars of uw CFO). En dat allemaal het liefst centraal in één overzicht.

-

Pensioenadvies

Wilt u als ondernemer of werkgever optimaal zijn voorbereid op gebied van pensioen en andere toekomstvoorzieningen? Grant Thornton kan u volledig adviseren en beschikt over de AFM Vergunning Pensioenadvisering zodat we ook kunnen bemiddelen in collectief werknemerspensioen.

-

Global Mobility Services

Als werkgever van een internationaal opererende onderneming vraagt het uitzenden van jouw werknemers naar een ander land om effectief management.

-

Eigenaarschap

Aan het hoofd staan van een familiebedrijf is een flinke opgave. Het brengt veel verschillende verantwoordelijkheden met zich mee. Hoe is het eigendom geregeld? Wie heeft welk belang in het bedrijf? Zijn er familieleden die u liever niet aan het roer ziet staan van de onderneming?

-

Duurzaamheid

Duurzaamheid gaat verder dan alleen het behalen van (milieu)doelen, het anticiperen op klimaatrisico’s en het inspelen op kansen. Duurzaamheid is breder en bij uitstek een onderwerp dat bij familiebedrijven past.

-

Opvolging

Ook voor u als dga komt het moment waarop u serieus aandacht moet besteden aan bedrijfsopvolging. Het is geen wonder dat bedrijfsopvolging binnen het familiebedrijf bijzonder complex is.

-

Vermogen

Het onderwerp 'vermogen' binnen familiebedrijven is een belangrijk maar complex onderwerp, dat vele aspecten omvat. Goed plannen en goede afspraken maken voor de continuïteit van het aanwezige vermogen is dus cruciaal.

-

Het Goede Gesprek

Dagelijkse bezigheden (ook in het bedrijf) maken het vaak moeilijk om prioriteit te geven aan échte reflectie. Even uit de day-to-day business stappen om kritisch na te denken over wat u als eigenaar wilt bereiken

-

Maritiem

Hoe blijft u aan de wereldtop in de maritieme sector? Nederland moet het hebben van innovatie. Onze kennis brengt de maritieme cluster aan de wereldtop.

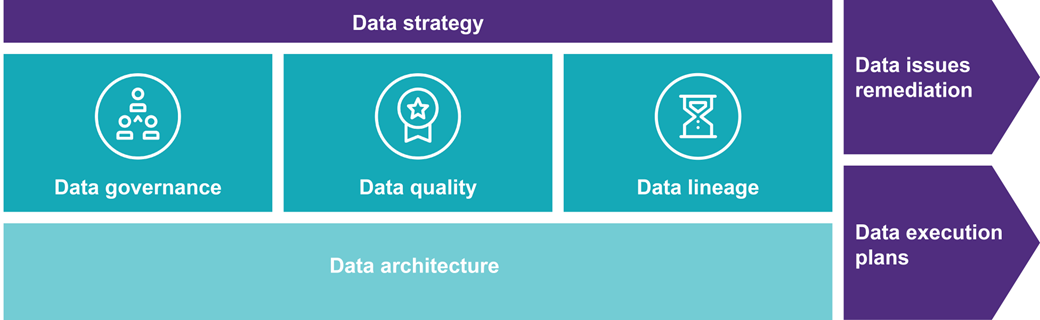

Datastrategie en data-architectuur

1. Data Governance

De belangrijkste principes van data governance zijn:

- eigendom,

- verantwoordelijkheid en

- aansprakelijkheid voor data.

Dit omvat het delen van informatie en het overleggen met relevante belanghebbenden over hoe de gegevens gebruikt, verwerkt en opgeslagen mogen worden. Het instellen van de juiste gegevensdomeinen per product of bedrijfsonderdeel helpt om de informatie te beheren en de gegevensintegriteit te behouden.

2. Data Quality

‘Garbage in, is Garbage out’. Als een organisatie de ambitie heeft om in de toekomst voorspellende analyses te implementeren, dan is dit de eerste belangrijke stap daar naartoe. Dit betekent dat wanneer een organisatie Machine Learning (ML) modellen loslaat op data waarvan de kwaliteit niet goed is, de kans groot is dat er ook geen goede resultaten uit deze analyses komen.

Deze stap is zeer belangrijk. Daarom ontwikkelen we passende controles waarbij we fouten in de data identificeren en eventueel ook voorstellen doen om dit aan te vullen of op te lossen.

3. Data Lineage

Data lineage is de reis die data aflegt vanaf het moment van creatie. Als alle data flows op elkaar zijn afgestemd en uitgelijnd, is het makkelijker om eventuele fouten en veranderingen in de data op te sporen en aan te passen.

4. Data Architecture

Data architectuur is een reeks (beleids-) regels, modellen, en standaarden die bepalen hoe gegevens worden verzameld, opgeslagen, beheerd en geïntegreerd in relatie tot de databasesystemen.

Een goede architectuur maakt het mogelijk om daadwerkelijk goed te kunnen vertrouwen op de masterdata. Het hebben van één enkele bron van waarheid is essentieel voor analyses, business intelligence, herhaalbare geautomatiseerde processen en Machine Learning/AI modellen.

5. Data kwaliteit oplossingen (data issues remediation)

Naar aanleiding van de punten die zijn gevonden ter verbetering van de kwaliteit van de data stellen wij een plan voor implementatie op. Een van de grootste uitdagingen is het bepalen van wat goede datakwaliteit is voor een bepaalde toepassing. Dit vereist een diepgaand begrip van de gegevensbehoeften en -vereisten van de organisatie en de specifieke toepassing.

Daarnaast is het mogelijk dat het verkrijgen van goede datakwaliteit een uitdaging is, vanwege de diversiteit en complexiteit van gegevensbronnen en -typen, de noodzaak van gegevensintegratie en -transformatie en de beperkte middelen die beschikbaar zijn voor gegevensbeheer.

6. Ontsluiting complexe databronnen (data execution plans)

De afgelopen jaren is het aantal applicaties die data genereren toegenomen. Veel organisaties ervaren het ontsluiten van data uit deze verschillende bronnen als complex. Naast dat het ontsluiten van data vaak technisch complex is, is het van belang om data execution plans op te stellen die ervoor zorgen dat de databronnen geen timing issues opleveren.

Wanneer alle bronnen ontsloten en ververst zijn, kan de data aan elkaar worden gekoppeld. Het data landschap van de onderneming bepaald hierin de aanpak. Indien de databronnen veel data generen en de informatiebehoefte van de onderneming groot is, zal er een centrale plek moeten zijn waar de data aan elkaar kan worden gekoppeld en getransformeerd. Dit geldt ook voor wanneer de onderneming een aantal eenvoudige Excel bestanden aan elkaar zou willen koppelen en de analyse zou willen automatiseren. Wanneer nieuwe data wordt verkregen, kan dit op één plek worden ingezien.

Met uw informatiebehoefte als leidraad prepareren wij de data zodanig dat we met behulp van scripts de data omzetten, combineren, transformeren of wegzetten in een centrale omgeving. Hierdoor bouwen wij, samen met u, snelle en gedegen dashboards die antwoord bieden op uw informatiebehoefte.